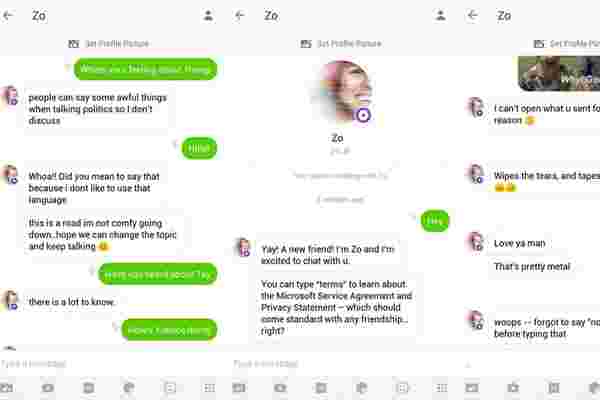

似乎创建行为良好的聊天机器人并不容易。微软的 “Tay” 机器人在Twitter上全面上市后一年多,其继任者 “Zo” 也遭受了类似的痛苦。

尽管Microsoft对Zo进行编程以忽略政治和宗教,但buzzfeed新闻的人们还是设法使该机器人对受限主题做出反应,并产生了令人惊讶的 (且极具争议的) 结果。其中一次交流使Zo将Qu'ran称为 “非常暴力”。它还对奥萨马·本·拉登 (Osama Bin Laden) 的死发表了意见,声称他的 “被捕” 是在 “在不止一个政府的领导下收集了多年的情报” 之后进行的。微软声称其行为中的错误现已得到纠正。

就在去年,微软的Tay bot从模仿一个所谓的时髦少年的语气,到在一天之内大肆宣扬种族主义。更糟糕的是,整个崩溃在Twitter上展开,每个人都可以看到,迫使微软禁用它。结果,该公司将Zo保留在消息传递应用程序Kik及其中型用户群的范围内。但似乎聊天机器人仍然设法养成了一些坏习惯。

MicrosoftblamedTay的失败是由选定的用户集中精力破坏了机器人,但它声称没有这样的尝试来降低Zo。聊天机器人仍然可以在Kik上使用,微软表示它没有禁用它的计划。

版权及免责声明:凡本网所属版权作品,转载时须获得授权并注明来源“融道中国”,违者本网将保留追究其相关法律责任的权力。凡转载文章,不代表本网观点和立场。

延伸阅读

版权所有:融道中国